반응형

[Team 1] Weekly Scrum_3

Contents

- 환경 구축- Hadoop Cluster 환경구축 - Spark Cluster 환경구축

- 데이터 테스트- local Spark에서 실데이터를 사용한 분석 테스트 - local Spark에서 ML 선형모델 테스트

Todos

- Spark로 data분석집값 결정 요인별 집값에 얼마나 영향을 주었는지 분석하기 ex) 강원도 집값이 올랐다면 작은 평수에서 올랐는지 높은 평수에서 올랐는지 그래프 보여주기

- 시각화- Zeppelin Cluster 환경구축 - Zeppelin 사용법 익히기

Done

- Hadoop Cluster 환경구축 및 데이터 Upload

- Spark Cluster 환경구축 및 local Spark환경에서 data 분석

[Team 1] Weekly Scrum 4

Contents

- 환경 구축- Zeppelin Cluster 환경구축

- 데이터 테스트집값 추이에 대해 Zeppelin으로 시각화 테스트

Todos

- Spark로 data분석- 추이분석 - 머신러닝 분석

- 시각화- 추이분석 시각화

Done

- Zeppelin yarn mode 환경구축

- 집값 추이에 대해 Zeppelin으로 시각화 테스트

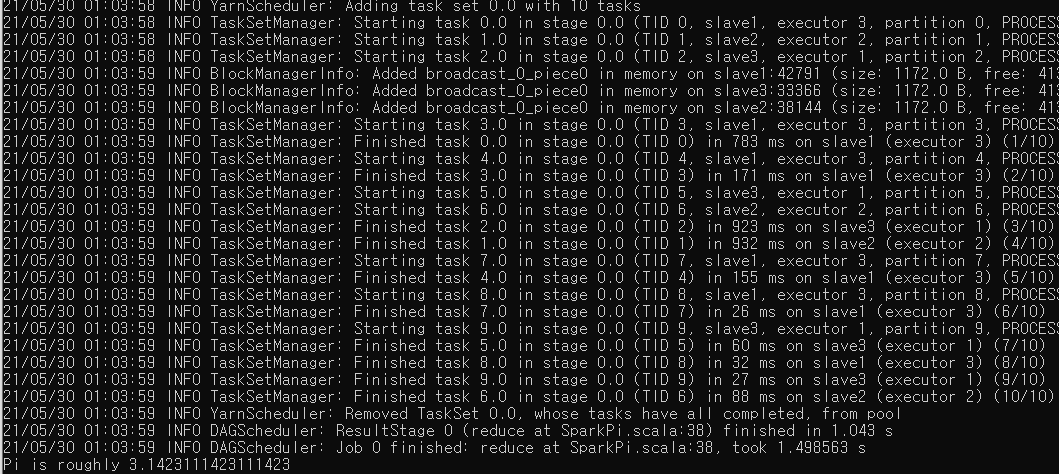

Spark yarn mode 구축(Spark 2.2.2 ver)

- Pi example

spark-submit --class org.apache.spark.examples.SparkPi --master yarn --deploy-mode client --num-executors 3 /usr/local/spark/examples/jars/spark-examples_2.11-2.2.2.jar 10

Zeppelin 설치(0.8.2 ver)

- 참고 사이트(zeppelin 부분만) : https://glow153.tistory.com/16

- yarn-mode 추가 설정 : https://zeppelin.apache.org/docs/0.7.0/install/spark_cluster_mode.html

- 참고 : 초기 설정으로는 Interpreter setting에 접근 권한이 없었음.

→ <Zeppelin_HOME>/conf/shiro.ini 에서 권한 설정.

- 설정한 포트로 Zeppelin UI 접속

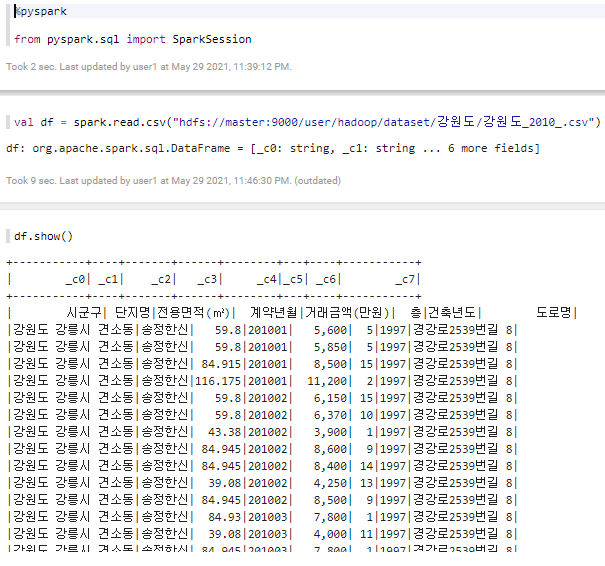

- HDFS에서 csv 파일 불러오기 테스트

Hadoop clustering → Spark Processing(yarn mode) → Zeppelin 시각화 까지 진행하기 위한 환경 구축 완료.

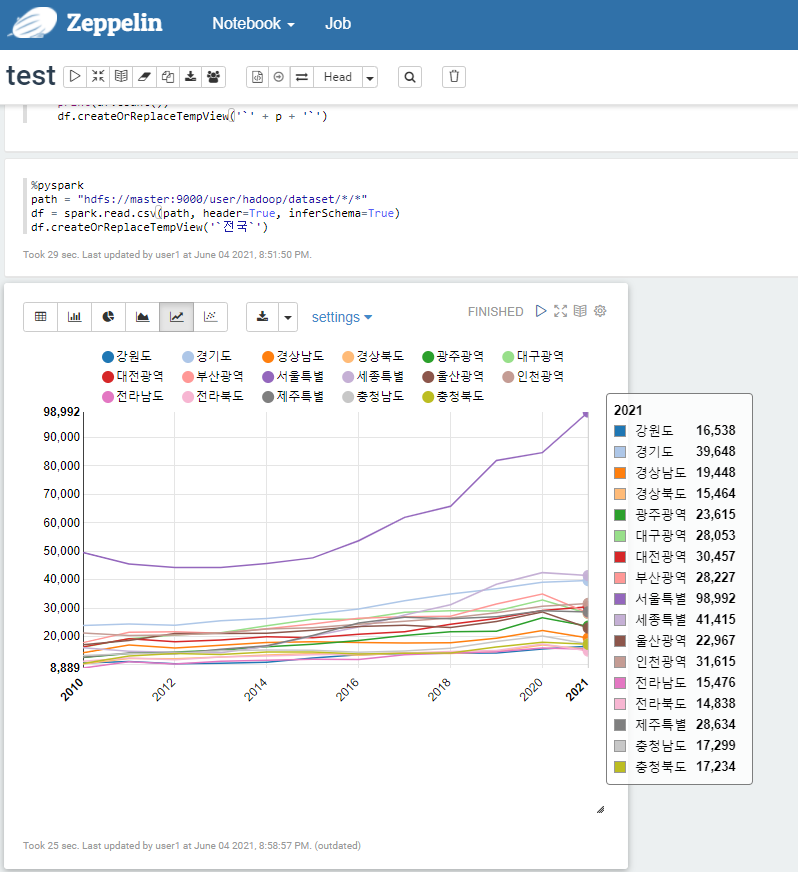

Zeppelin test

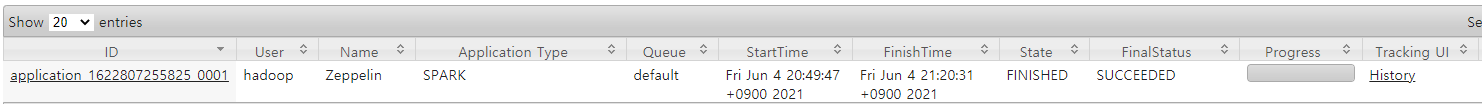

Resource Manager UI

프로젝트 진행 중

- zeppelin에서는 내부의 다이나믹 폼, 차트를 다른 웹사이트에 쉽게 적재할 수 있으며 동적으로 link 된다.

- 따라서 웹사이트에서 zeppelin의 paragraph들을 이용해서 쉽게 포스트 할 수 있도록 zeppelin에서 구현하면 추가적인 작업을 많이 줄여줄 수 있을 것 같다.

- 여러 가지 기준(지역, 아파트별, 면적, 층수 등)에 따라 아파트 가격 변화 추이를 보여주는 것을 목표로 하기 때문에 입력을 받는 paragraph와 각 기준별 chart를 보여주기 위한 paragraph를 분리하고 각각을 웹사이트에 적절하게 연결만 해주면 될 것 같다.

- zeppelin에는 Zeppelin Context로 변수 z를 사용하여 다양한 기능을 사용할 수 있다.

- z.run()이라는 함수로 특정 paragraph에서 또 다른 paragraph를 실행시킬 수 있다.

- ex - 입력 paragraph에서 값을 받고 해당 값이 필요한 chart를 모두 run시킨다.

- zeppelin의 pragraph끼리는 변수의 전달이 안된다. (sparkSession은 된다.)

- z.put & z.get을 사용해서 paragraph간 변수 전달을 한다.

- DataFrame은 paragraph간 공유가 된다.(하지만 paragraph interpreter는 같아야함)

- zeppelin에는 Zeppelin Context로 변수 z를 사용하여 다양한 기능을 사용할 수 있다.

- 기능 구현 상황

- 지역별 아파트 매매가 변화 추이 검색, 그래프 보여주기

- 해당 지역 이하의 아파트 매매가 변화 추이 검색, 그래프 보여주기

- 아파트 매매가 변화 추이 검색시, sparkML로 다음 연도 매매가 회귀 예측 보여주기

Troubles

- pyspark - python 버전 에러가 뜨며 install numpy가 잘 안되었다. numpy는 spark.ml을 사용하기 위해 꼭 필요하다. (Ubuntu도 16.x 버전으로 오래전 버전이라 영향이 있는 것 같다.) Ubuntu16.x는 python3.5x로 실행되는 많은 프로그램이 있기 때문에 python 버전을 아예 바꾸는 것은 리스크가 있다고 한다.

- python3.7 받아서 spark-env.sh의 driven_path만 python3.7 경로로 바꿔주고 numpy는 python3.7 -m pip install numpy로 사용하는 버전에 모듈 다운로드. (당연히 job이 실행되는 모든 DataNode에 해줘야 한다)

반응형

'IT study > Big Data' 카테고리의 다른 글

| 아파트 가격 추이 분석 서비스(4) (0) | 2021.06.13 |

|---|---|

| [YouTube]Apache Spark Tutorial Full Course - Spark SQL&basic (5) (0) | 2021.05.28 |

| 아파트 가격 추이 분석 서비스(2) (0) | 2021.05.22 |

| 아파트 가격 추이 분석 서비스(1) (0) | 2021.05.22 |

| [YouTube]Apache Spark Tutorial Full Course - RDD Creation (4) (0) | 2021.05.17 |