반응형

Weekly Scrum Meeting

Contents

1) 추이

- Spark를 사용해서 다양한 요인에 의한 집값 변화 추이 분석하기(세부 기능 회의 중)

2) 예측 : ML 모델링

- 10년치 data에 대해 선형모델을 적용하면 대체로 집값이 오르는 것으로 예측 → 의미 X

- 분석할 아파트 요인별로, 최근 2년간 월별 데이터를 통해 선형 예측값을 보여주기로 결정

Todos

- Hadoop Cluster 환경구축 및 HDFS에 data 저장

- Spark로 data분석집값 결정 요인별 집값에 얼마나 영향을 주었는지 분석하기 ex) 강원도 집값이 올랐다면 작은 평수에서 올랐는지 높은 평수에서 올랐는지 그래프 보여주기

- 시각화 tool 정하기- spark와 연동되어야 함 - python lib고려(지도 시각화)

Done

- 부동산 뉴스 제목 크롤러 구현 완료

- ML 선형모델 프로토타입 구축 완료 (임의의 시를 기준으로 테스트 완료)

- 아파트 매매 실거래가 데이터 정제 완료

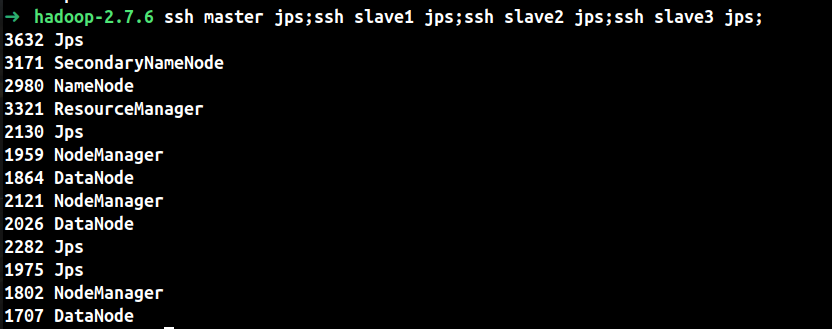

Hadoop Cluster 구축 완료(2.7.6 ver)

Spark Local로 pyspark분석 실험

- windows local에서 ubuntu로 데이터셋 옮기기

cd /mnt # 마운트 폴더로 이동 -> c드라이브 접근

cp {windows에 file path} {ubuntu save path}

- 개별 csv file에 skip해야 할 row가 조금 있었는데 DataFrame으로 read.csv시 해당 부분을 skip하는데 문제가 생겼다.

Python Pandas의 dataframe처럼 skiprows를 할 수 있을줄 알았는데 찾아보니 csv를 RDD로 생성하여

mapping하는식으로 skiprows를 해야한다고 한다...

상관은 없지만 다양한 분석을 할때마다 작업하기 보다는 파일 자체를 다시 고치는게 나을 것 같다.

다행히 지역별, 연도별로 폴더화가 잘 되어 있어서 간단하게 파일을 수정했다.

import pandas as pd

provinces = ['강원도','경기도','경상남도','경상북도','광주광역시','대구광역시','대전광역시','부산광역시','서울특별시','세종특별자치시','울산광역시','인천광역시','전라남도','전라북도','제주특별자치도','충청남도','충청북도']

years = list(range(2010, 2022))

for p in provinces:

basic_folder = f'/home/user/dataset/{p}/{p}_'

for y in years:

df = pd.read_csv(basic_folder + str(y) + '.csv', encoding='CP949', skiprows=2)

df.to_csv(basic_folder + str(y) + '.csv', index=False)

추가로,

sparkSQL을 사용해 보고,

Spark ML로 간단한 선형회귀를 테스트해보았다.

반응형

'IT study > Big Data' 카테고리의 다른 글

| 아파트 가격 추이 분석 서비스(3) (0) | 2021.05.30 |

|---|---|

| [YouTube]Apache Spark Tutorial Full Course - Spark SQL&basic (5) (0) | 2021.05.28 |

| 아파트 가격 추이 분석 서비스(1) (0) | 2021.05.22 |

| [YouTube]Apache Spark Tutorial Full Course - RDD Creation (4) (0) | 2021.05.17 |

| [YouTube]Apache Spark Tutorial Full Course - Job, Stage, Task (3) (0) | 2021.05.12 |